W erze nowoczesnych technologii, które dynamicznie zmieniają nasze codzienne życie, automatyzacja oraz przenoszenie procesów do świata wirtualnego staje się coraz bardziej powszechne. Jednym z obszarów, który może zyskać na innowacyjnych rozwiązaniach, jest rekrutacja. Wirtualna Rzeczywistość (VR) oferuje nowe, immersyjne doświadczenia, które mogą znacząco wpłynąć na sposób, w jaki kandydaci wchodzą w interakcje z przyszłymi pracodawcami.

Niniejszy projekt badawczy analizuje wpływ VR na proces rekrutacyjny, porównując tradycyjną aplikację webową z jej bardziej zaawansowanym odpowiednikiem opartym na technologii VR.

W artykule chciałbym przedstawić mój projekt, który jest w ciągłym rozwoju. Krótko omówię technologie zastosowane w projekcie, szczegółowo zaprezentuję wersję VR aplikacji oraz przedstawię aktualny stan prac i plan dalszego rozwoju projektu.

Główna struktura projektu

Backend

- Spring Boot – backend aplikacji oparty na Spring Boot zarządza logiką biznesową oraz danymi użytkowników, kandydatów i administratorów. Spring Boot pozwala na szybkie tworzenie skalowalnych aplikacji, które mogą być łatwo integrowane z frontendem. Framework ten zapewnia efektywne operacje CRUD (Create, Read, Update, Delete) w połączeniu z bazą danych oraz wspiera zarządzanie procesami biznesowymi.

- PostgreSQL – do przechowywania danych aplikacyjnych wykorzystano bazę danych PostgreSQL, charakteryzującą się wysoką wydajnością i stabilnością. Umożliwia obsługę dużej liczby zapytań oraz przechowywanie danych kandydatów, ofert pracy i wyników rekrutacji. PostgreSQL oferuje zaawansowane funkcje, takie jak transakcje, indeksowanie i zaawansowane zapytania.

- Keycloak – system Keycloak jest używany do uwierzytelniania i autoryzacji użytkowników. Oferuje zarządzanie sesjami użytkowników, możliwość logowania przez różne platformy (Google, Facebook), kontrolowanie ról (kandydat, administrator) oraz zapewnia zaawansowane zabezpieczenia.

Frontend – wersja webowa

- React.js – frontend aplikacji webowej został stworzony w React.js, co pozwala na dynamiczne renderowanie i szybkie ładowanie interfejsu użytkownika. React.js umożliwia budowanie komponentów UI, które dostosowują się do różnych rozmiarów ekranów i urządzeń, co poprawia responsywność aplikacji.

- Material-UI – wykorzystanie komponentów Material-UI umożliwia tworzenie nowoczesnych i estetycznych interfejsów użytkownika. Oferuje zestaw gotowych komponentów zgodnych z zasadami projektowania Material Design, co wpływa na intuicyjność i łatwość w nawigacji po aplikacji.

Wersja VR

- Unity – silnik Unity jest używany do stworzenia wirtualnego środowiska biurowego, które pozwala kandydatom na swobodne poruszanie się i interakcję z otoczeniem. Unity wspiera zaawansowane techniki graficzne oraz fizykę, umożliwiając stworzenie realistycznego i immersyjnego doświadczenia.

- Blender – modelowanie poszczególnych elementów wirtualnego biura, takich jak meble, komputery i dekoracje, zostało zrealizowane przy pomocy Blendera.

- Photon Network i Photon Voice – technologia Photon Network wspiera tryb multiplayer, umożliwiając interakcję w czasie rzeczywistym w tym samym wirtualnym biurze. Photon Voice zapewnia wysoką jakość komunikacji głosowej, co wzbogaca interakcję podczas rozmów kwalifikacyjnych.

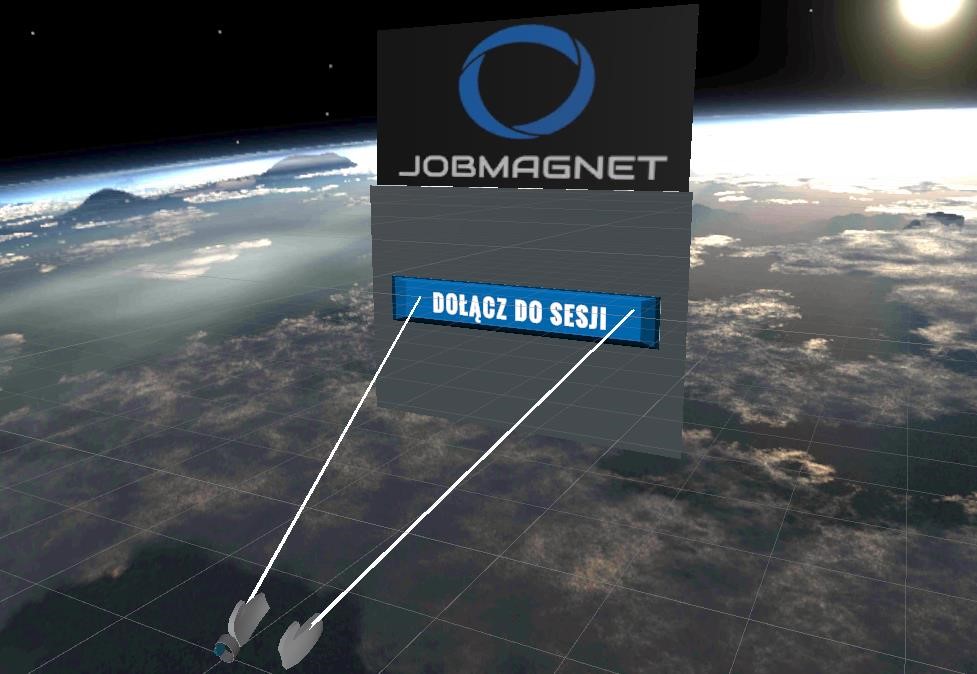

Pierwsze spotkanie

W ramach wersji VR aplikacji rekrutacyjnej, pierwszą sceną, z którą użytkownik ma styczność, jest panel dołączania do serwera. Scena ta jest bramą wejściową do pozostałych funkcji aplikacji.

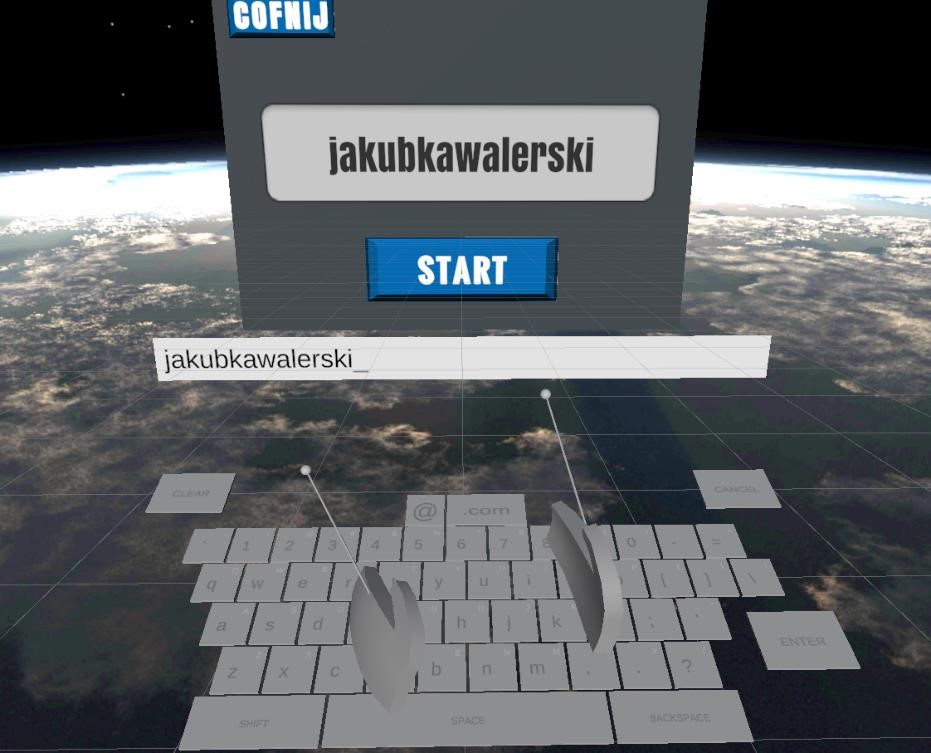

Panel ten uruchamia się w kosmicznym otoczeniu, dodając tym samym unikalny element immersji dla użytkownika. W tym środowisku użytkownik ma pierwszą możliwość interakcji z aplikacją, a mianowicie wprowadzenia swojego pseudonimu, który będzie reprezentować go w późniejszych etapach korzystania z aplikacji.

Jednym z najważniejszych elementów tej sceny jest wirtualna klawiatura zaimplementowana dzięki pluginowi VR Keys. Została ona zaprojektowana tak, aby użytkownik mógł wprowadzać tekst sposób intuicyjny i realistyczny w środowisku VR. Klawiatura jest trójwymiarowa i wymaga od użytkownika namierzenia konkretnego klawisza za pomocą kontrolera ruchu, a następnie jego „naciśnięcia”.

Po wprowadzeniu, nazwa użytkownika jest wyświetlana jako etykieta nad avatarem w środowisku wirtualnym. To kluczowy element, który umożliwia innym uczestnikom rozpoznanie użytkownika w trakcie interakcji w różnych częściach aplikacji.

Wybór avatara i dołączanie do sesji

Po zalogowaniu, użytkownik trafia do lobby, gdzie wybiera avatara na specjalnej platformie z prefabrykatem współpracującym z Photon Network. Dzięki tej integracji wybrany avatar jest synchronizowany dla wszystkich uczestników sesji. Platforma wyboru jest intuicyjna, umożliwia nawigację między modelami 3D za pomocą przewijania w lewo i prawo.

W lobby znajduje się także system lustra z optymalizowanym shaderem, realistycznie odzwierciedlającym postać i ruchy. Kamera obserwacyjna przechwytuje obraz z różnych kątów, a zmiany avatara są natychmiast widoczne w lustrze. Integracja z Photon Network zarządza sesjami sieciowymi, a kluczowe ustawienia są konfigurowane przez „Photon Server Settings”, co ułatwia zarządzanie aplikacją i limitami graczy.

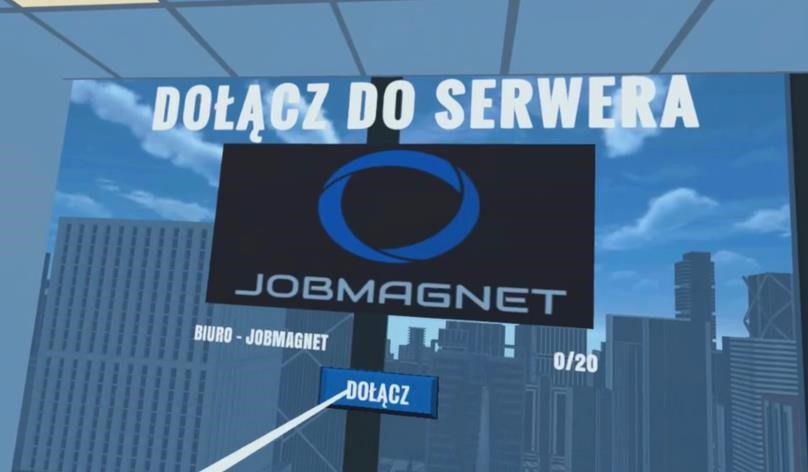

W obecnej konfiguracji dostępna jest jedna sesja o nazwie „Biuro Job Magnet”. Po jej wybraniu z panelu interfejsu użytkownika następuje seria wywołań metod Photon API. Obejmuje to między innymi proces autentykacji, dołączenia do konkretnej sesji oraz synchronizację stanów w czasie rzeczywistym.

Warto zauważyć, że projekt korzysta z darmowej wersji Photon Network, która umożliwia obsługę do 20 użytkowników jednocześnie. Dla celów projektu jest to rozwiązanie więcej niż wystarczające, eliminując potrzebę inwestowania w bardziej rozbudowane plany płatnościowe. Dzięki zastosowaniu Photon API, zarządzanie sesjami jest nie tylko efektywne, ale także elastyczne, co pozwala na skalowanie projektu w przyszłości.

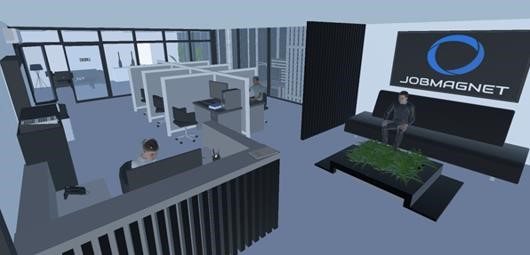

Wirtualne biuro JobMagnet – interakcje i nawigacja

Wirtualne biuro zostało zaprojektowane z myślą o intuicyjności i funkcjonalności, aby użytkownicy mogli swobodnie poruszać się i komunikować w tej przestrzeni.

Użytkownik porusza się po wirtualnym biurze za pomocą lewej gałki sterującej na lewym kontrolerze ruchu. Gałka ta odpowiada za płynne i precyzyjne przemieszczanie się postaci między różnymi strefami w biurze. W prawym kontrolerze ruchu znajduje się druga gałka, która umożliwia obrót „kamery”, czyli zmianę perspektywy widzenia lewo-prawo, co zwiększa komfort nawigacji i pozwala na łatwiejsze skanowanie otoczenia.

Głos i dźwięk

Wirtualne biuro wykorzystuje Photon Voice dla realizacji chatu głosowego, zapewniając wysoką jakość dźwięku i minimalne opóźnienia. Technologia ta jest zintegrowana z Photon Network, synchronizując głos pomiędzy różnymi uczestnikami sesji.

W celu intuicyjnej wizualizacji użycia mikrofonu i głośników, zaimplementowano system ikon wyświetlanych nad avatarami użytkowników. Gdy użytkownik korzysta z mikrofonu, nad jego avatarem pojawia się ikona mikrofonu. Odpowiednio, gdy inny użytkownik mówi, nad jego avatarem wyświetlana jest ikona głośnika.

Unikatową cechą chatu głosowego w tym środowisku jest zastosowanie zróżnicowanej głośności dźwięku w zależności od odległości pomiędzy użytkownikami. Dzięki temu, rozmowy są bardziej realistyczne i immersyjne, co dodatkowo wpływa na komfort i jakość komunikacji. W praktyce oznacza to, że im bliżej siebie znajdują się użytkownicy, tym głośniej słyszą się nawzajem, co imituje naturalne warunki rozmowy.

Interakcje

W środowisku wirtualnego biura zintegrowano także funkcję, która umożliwia użytkownikowi powrót do lobby. Po kliknięciu ikony „X” na interfejsie pojawia się nałożony panel z guzikiem, który po aktywacji przenosi użytkownika z powrotem do głównego lobby. Ta funkcjonalność dodaje warstwę komfortu i elastyczności, pozwalając użytkownikom łatwo przełączać się między różnymi częściami aplikacji.

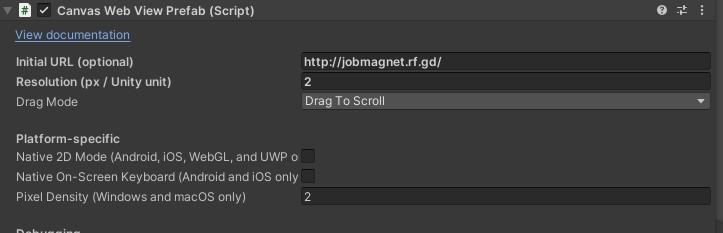

Integracja zewnętrznej aplikacji webowej w wirtualnym biurze została zrealizowana za pomocą pluginu Vuplex WebView. Plugin ten umożliwia wyświetlanie zeskalowanego i optymalizowanego interfejsu aplikacji webowej bezpośrednio w wirtualnym środowisku. Użytkownik może aktywować ekran aplikacji w dowolnym miejscu biura, naciskając przycisk „Y” na lewym kontrolerze. Po tej akcji, ekran z interfejsem aplikacji webowej pojawia się przed użytkownikiem, wraz z dedykowaną, interaktywną klawiaturą wirtualną.

Klawiatura ta jest zoptymalizowana pod kątem interakcji z aplikacją, umożliwiając wprowadzanie danych, przeglądanie zawartości i wykonywanie innych zadań, które normalnie wymagałyby korzystania z tradycyjnej klawiatury i myszy. Co nie oznacza, że nie można podłączyć zewnętrznych urządzeń Bluetooth. Dzięki takiemu rozwiązaniu, użytkownicy, którzy czują się bardziej komfortowo z tradycyjnymi metodami wprowadzania danych, mogą również na swój sposób interaktywnie korzystać z aplikacji webowej w środowisku wirtualnym. Ta elastyczność w obszarze interakcji dodatkowo podnosi użyteczność i dostępność całego wirtualnego biura.

Dodatkowo, WebView jest podpięty do domeny, na której hostowana jest aplikacja, co eliminuje potrzebę dodatkowego obciążania sprzętu użytkownika. Zamiast tego, zasoby są pobierane i przetwarzane na zewnętrznym serwerze, co znacząco wpływa na optymalizację i wydajność.

Ten mechanizm dodaje dodatkowy poziom interaktywności i funkcjonalności do wirtualnego biura, umożliwiając użytkownikowi swobodny dostęp do zasobów i narzędzi webowych bez konieczności opuszczania wirtualnej przestrzeni.

Modelowanie środowiska 3D

Kreacja wirtualnego biura w Unity Editor obejmowała kilka etapów technicznych. Elementy takie, jak biurka, krzesła, dekoracje czy interaktywne panele zostały umieszczone w trójwymiarowej siatce (grid) koordynatów przestrzennych. W tym kontekście, praktyki takie, jak 'snapping’ oraz 'parenting’ były często wykorzystywane dla precyzyjnego rozmieszczenia i relacyjnego pozycjonowania obiektów. Ważnym aspektem było również zastosowanie różnych technik skalowania i transformacji, korzystając z mechanizmów takich, jak 'Transform’ component w Unity. To pozwalało na dynamiczną manipulację wielkością, orientacją i pozycją każdego z elementów w czasie rzeczywistym.

Zastosowanie technik 'lightmappingu’ oraz 'occlusion culling’ dodatkowo podnosiło poziom realizmu i efektywności renderowania, minimalizując jednocześnie obciążenie dla silnika gry. Wszystko to miało na celu stworzenie środowiska, które nie tylko jest atrakcyjne wizualnie, ale również zoptymalizowane pod kątem wydajności.

Część komponentów wirtualnego biura była zbyt specyficzna, by móc korzystać z dostępnych prefabrykatów. Dlatego te unikatowe elementy zostały stworzone manualnie w programie Blender. Po zakończeniu procesu modelowania, elementy były eksportowane do formatów .FBX lub .OBJ, co pozwalało na ich dalszą manipulację i integrację w Unity. Ten etap pracy również obejmował techniczne aspekty takie, jak mapowanie UV, naniesienie tekstur i kalibracja shaderów, aby zachować spójność wizualną i jakość detali w finalnym produkcie.

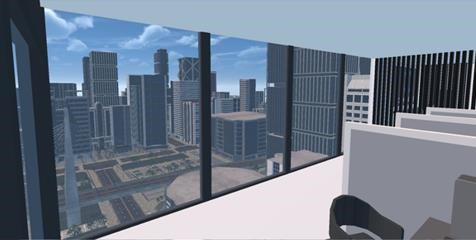

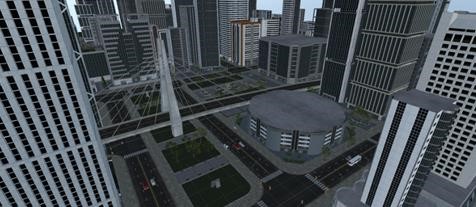

Wizualizacje zewnętrzne, postprocesing i animacje NPC

Kluczowym elementem w kreacji realistycznego widoku zewnętrznego jest zastosowanie narzędzi AI. Narzędzia oparte są na zaawansowanych algorytmach proceduralnych, które z automatu generują dynamiczne i złożone struktury miejskie. Chociaż narzędzie to oferuje szerokie możliwości konfiguracji, wymagało ono również spersonalizowanego dostosowania do specyficznych potrzeb projektu. Elementy takie, jak gęstość zabudowy, typy i wysokość budynków, układ dróg i wielu innych zostały ręcznie skonfigurowane w edytorze Unity, aby osiągnąć zamierzony efekt wizualny i funkcjonalny.

Poza generowaniem struktury miasta, plugin został zintegrowany z mechanizmami postprocesingu dostępnymi w Unity. Obejmuje to generowanie realistycznego ruchu ulicznego przy wykorzystaniu systemów cząsteczkowych oraz narzędzi nawigacyjnych Unity takich, jak NavMesh Agents. Każdy pojazd i przechodzień na scenie jest sterowany przez algorytmy, które w real-time’ie symulują ich zachowania. Dynamiczne zmienne takie, jak prędkość, kierunek, i gęstość ruchu są ręcznie konfigurowane i na bieżąco aktualizowane, co dodaje warstwę realizmu do generowanej sceny.

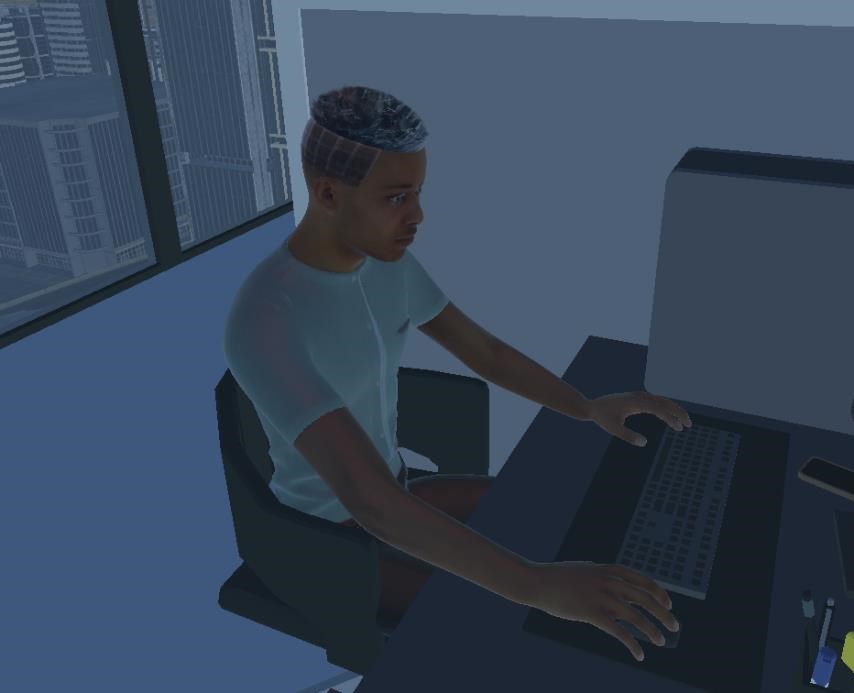

Projektowanie NPC

W projektowaniu NPC (Non-Player Characters) kluczową rolę odgrywa Adobe Maximo, które stanowi platformę do tworzenia, zarządzania i eksportowania zaawansowanych animacji. Zdefiniowane w Maximo animacje są eksportowane w formie plików FBX, a następnie importowane do Unity. Ważnym krokiem jest konfiguracja modeli NPC w Unity na typ 'Humanoid’ w avatarze Unity, co umożliwia poprawne mapowanie kości i sterowanie animacjami.

Po zaimportowaniu, animacje są integrowane z Mechanizmem Animatora w Unity. Jest to etap, na którym konfigurujemy różne stany i parametry takie, jak prędkość, pozycja czy wyzwalacze, aby uzyskać płynność i naturalność ruchów.

Optymalizacja aplikacji

Optymalizacja aplikacji VR, w szczególności na tak specyficzną platformę jak Oculus Quest 2, jest procesem złożonym i wymagającym. Wykorzystując bogatą dokumentację i zasady optymalizacji dostarczone przez Meta Platforms, Inc., przeanalizowano i wprowadzono szereg modyfikacji w różnych aspektach projektu.

Konfiguracja środowiska

- Platforma i SDK – w Unity, w sekcji Build Settings, target platform została ustawiona na Android z konkretną wersją SDK zgodną z Oculus Quest 2.

- Architektura i Instrukcje – w Project Settings, zakładka Player, podpunkt Other Settings, wybrano architekturę ARM64 oraz ustawiono API Level zgodnie z rekomendacjami Meta.

- Formaty Tekstur i Kompresja – ustawienia Importerów tekstur zostały zaktualizowane, aby korzystać z formatów kompresji ASTC lub ETC2, zgodnie z rekomendacjami dla Oculus Quest 2.

Proces optymalizacyjny

- Analiza profilera – zaawansowane korzystanie z Unity Profilera, zwracając uwagę na aspekty takie, jak wykorzystanie CPU, ilość trójkątów i draw calls.

- Zoptymalizowane assets – implementacja systemów LOD (Level Of Detail), zarządzanie danymi przez scriptable objects i zastosowanie technik takich, jak occlusion culling.

- Optymalizacja skryptów – wprowadzenie rozwiązań takich, jak Object Pooling, batch processing, i minimalizacja garbage collection poprzez zastosowanie struktur danych niealokujących pamięci dynamicznie.

- Techniki renderingu – optymalizacja poprzez techniki takie, jak baked lighting, deferred rendering oraz unikanie overdraw, przez inteligentne zarządzanie warstwami i transparencją.

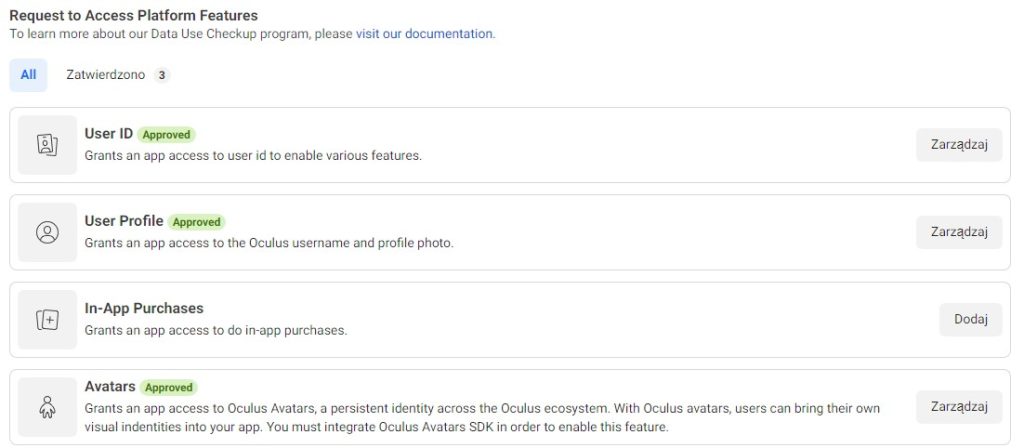

Problem badawczy – integracja Meta-Awatarów i kwestie kompatybilności

Integracja Meta-Awatarów w aplikacji Unity3D napotkała wiele wyzwań. Kluczowym problemem była konieczność rejestracji i zatwierdzenia aplikacji w portalu deweloperskim Meta, co znacznie opóźniało rozwój. Dodatkowo, testowanie było utrudnione przez dynamiczne ładowanie awatarów z kont Oculus, wymagające dwóch urządzeń Oculus Quest 2, co komplikowało logistykę i koszty projektu.

Najpoważniejszym wyzwaniem okazało się ograniczenie funkcjonalności Meta-Awatarów w zakresie interakcji z wirtualnym ekranem, co było kluczowe dla projektu. Aplikacja webowa wymagała pełnej manipulacji interfejsem, czego Meta-Awatarom brakowało.

Kompatybilność z OpenXR wprowadziła kolejne trudności, wymagając licznych adaptacji kodu. Diagnostyka i wsparcie techniczne Meta były niezbędne, ale proces rozwiązywania problemów był czasochłonny i wymagał dogłębnej wiedzy o OpenXR i Meta-Awatarach.

Ostatecznie, udało się stworzyć alternatywną wersję aplikacji, która zawiera MetaAwatary i oferuje funkcje wieloosobowe (multiplayer). W tej wersji, jednakże, nie ma możliwości korzystania z wbudowanego ekranu wirtualnego z aplikacją webową.

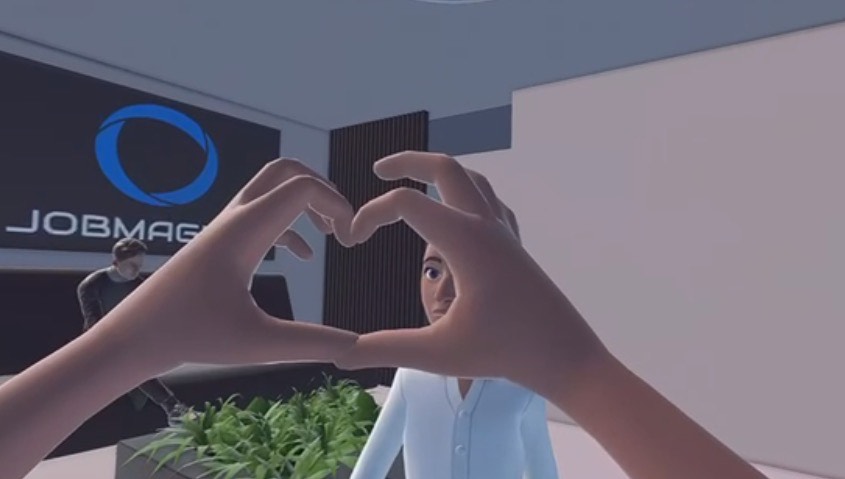

Wersja projektu z Meta-Awatarów wykorzystuje zaawansowane techniki widzenia komputerowego do śledzenia ruchów rąk użytkownika. Dzięki zastosowaniu kamery wewnątrz urządzenia Oculus Quest 2, algorytmy sztucznej inteligencji analizują obraz w czasie rzeczywistym, identyfikując kluczowe punkty na dłoniach i palcach. Ta informacja jest następnie przetwarzana przez sieci neuronowe, co pozwala na dynamiczne mapowanie ruchów rąk użytkownika na ruchy awatara w wirtualnym świecie.

Technologia ta pozwala na niezwykle precyzyjne śledzenie ruchów, co otwiera drzwi do różnorodnych form interakcji. Na przykład, dzięki temu możemy wykorzystać gesty do komunikacji niewerbalnej, manipulowania obiektami w wirtualnym środowisku, czy nawet skomplikowanych działań takich, jak rysowanie czy pisanie w powietrzu. Wszystko to jest możliwe dzięki zaawansowanemu modelowi uczenia maszynowego, który wciąż się „uczy” na podstawie zgromadzonych danych, stając się coraz bardziej precyzyjnym i responsywnym.

Chociaż wersja z Meta-Awatarów nie zawiera ekranu wirtualnego, jej potencjał w zakresie interaktywności i immersji jest znaczący i nie można go lekceważyć w kontekście badawczym tego projektu. Umożliwia ona wykorzystanie zaawansowanych technologii widzenia komputerowego i sztucznej inteligencji do analizy ruchów rąk w czasie rzeczywistym. Ta funkcja dostarcza dodatkowej warstwy interakcji, która może służyć jako katalizator dla bardziej zaawansowanych form komunikacji i interakcji w wirtualnym środowisku.

Zważywszy na te zalety, istnieje spore prawdopodobieństwo, że w przyszłości obie wersje projektu będą mogły zostać zintegrowane. To otworzyłoby możliwość połączenia interaktywności ekranu wirtualnego z zaawansowanym poziomem immersji oferowanym przez Meta-Awatary. Taka synergia mogłaby zdecydowanie podnieść jakość użytkowania i funkcjonalność całego projektu, tworząc kompleksowe i wszechstronne rozwiązanie dla różnorodnych zastosowań w wirtualnej rzeczywistości.

Obecny stan projektu i jego przyszłość

Obecny wygląd projektu został stworzony jako część mojej pracy inżynierskiej oraz prywatnego rozwoju. Udało się zintegrować MetaAvatary z pozostałymi funkcjami aplikacji.

W przyszłych etapach rozwoju aplikacji VR planowane jest rozszerzenie funkcji interakcji za pomocą gestów, co uczyni doświadczenie bardziej naturalnym i intuicyjnym. Obecnie system rozpoznaje podstawowe gesty rąk, takie jak zginanie palców i proste ruchy. Planuję jednak wprowadzenie zaawansowanych technik rozpoznawania gestów dzięki technologii widzenia komputerowego i sztucznej inteligencji. Nowe rozwiązania będą umożliwiać precyzyjne manipulowanie obiektami, bardziej zaawansowaną nawigację po przestrzeni oraz bogatszą komunikację niewerbalną. Celem jest dalsze wzbogacenie procesu rekrutacyjnego i uczynienie go bardziej immersyjnym oraz angażującym dla kandydatów.

Rozwój ten będzie kluczowym elementem mojej pracy magisterskiej, w której zamierzam kontynuować prace nad udoskonaleniem i implementacją nowych rozwiązań w obszarze AI.

Czy ktoś z Was ma może pomysły na to, jak jeszcze można ulepszyć projekt pod względem rozpoznawania gestów w wirtualnej rzeczywistości? Chętnie poznam Wasze sugestie i opinie!

Podsumowanie

Projekt aplikacji rekrutacyjnej wykorzystujący Wirtualną Rzeczywistość (VR) łączy szereg nowoczesnych technologii, tworząc innowacyjne i angażujące środowisko rekrutacyjne. Wykorzystanie Spring Boot i PostgreSQL do zarządzania logiką biznesową i danymi użytkowników zapewnia solidną i skalowalną bazę backendową. Z kolei Keycloak umożliwia bezpieczne uwierzytelnianie i autoryzację użytkowników, co jest kluczowe dla ochrony danych kandydatów.

Na froncie webowym użycie React.js i Material-UI pozwala na stworzenie nowoczesnego i responsywnego interfejsu użytkownika. Natomiast wersja VR, zbudowana przy użyciu Unity i Blender, wprowadza użytkowników do wirtualnego biura, które oferuje interaktywne doświadczenia z realistycznym modelowaniem i grafiką. Photon Network i Photon Voice dodają możliwość interakcji w czasie rzeczywistym, umożliwiając komunikację głosową i wspólne przebywanie w tej samej wirtualnej przestrzeni.

Tego typu rozwiązanie nie tylko unowocześnia procesy rekrutacyjne, ale także czyni je bardziej angażującymi i spersonalizowanymi. Kandydaci mogą lepiej poznać firmę i zespół, z którym potencjalnie będą współpracować, co może zwiększyć ich motywację i pewność, co do wyboru pracodawcy. W przyszłości planowane jest dalsze wzbogacenie funkcjonalności, w tym integracja zaawansowanego rozpoznawania gestów, co jeszcze bardziej zwiększy immersyjność i naturalność interakcji w środowisku VR.

Implementacja takich technologii nie tylko podnosi standard procesu rekrutacji, ale także pozytywnie wpływa na wizerunek firmy, prezentując ją jako nowoczesną i innowacyjną organizację otwartą na nowe rozwiązania. Może to przyciągnąć ambitnych i technologicznie zaawansowanych kandydatów, gotowych do współpracy z firmą, która stawia na przyszłość i innowacje.

Bardzo ciekawy pomysł i świetne wykonanie. Co gdyby spróbować przenieść podobną wizję do świata BHP, w celu, na przykład, symulacji niebezpiecznego środowiska pracy i ćwiczeń w takim środowisku?

Pozdrawiam!

Świetny pomysł! Wykorzystanie technologii VR w rekrutacji to rewolucyjny krok, który otwiera nowe możliwości dla firm i kandydatów. Zdalne rozmowy kwalifikacyjne w wirtualnej rzeczywistości to innowacja, która może zmienić przyszłość rekrutacji – szybciej, efektywniej i bardziej interaktywnie.