Jako architekt cyberbezpieczeństwa uważam, że nadążanie za nowymi technologiami i ich wpływem na bezpieczeństwo i etykę jest kluczowe. Jedną z takich technologii jest Llama 3 od Meta – nowoczesny model językowy zaprojektowany do generowania tekstu przypominającego ludzki.

W tym artykule przyjrzymy się koncepcji zabezpieczeń w Llama 3 i temu, jak zapewniają one bezpieczne i etyczne użycie modelu.

Czym są Guardrails w Llama 3?

Guardrails w Llama 3 to środki ochronne wdrożone w celu zapobiegania generowaniu przez model szkodliwych, nieetycznych lub niebezpiecznych treści. Środki te są niezbędne w świecie, w którym możliwości sztucznej inteligencji szybko się rozwijają, a potencjał nadużyć jest wysoki.

Dlaczego Guardrails są tak ważne?

Modele sztucznej inteligencji, takie jak Llama 3, mogą generować niezwykle realistyczny tekst, co jest zarówno mocną stroną, jak i potencjalnym zagrożeniem. Bez odpowiednich zabezpieczeń są w stanie generować nieodpowiednie treści, dezinformacje, a nawet złośliwy kod. Guardrails pomagają ograniczyć to ryzyko, odfiltrowując szkodliwe treści i zapewniając przestrzeganie standardów etycznych.

Kluczowe zabezpieczenia w Llama 3

- Bezpieczeństwo treści –Llama 3 zawiera mechanizmy klasyfikacji i filtrowania niebezpiecznych treści, zapobiegając generowaniu tekstu związanego z przemocą, samookaleczeniem, nielegalnymi działaniami i innymi wrażliwymi tematami.

- Ograniczenia etyczne i prawne –model został zaprojektowany tak, aby unikać generowania treści, które mogłyby prowadzić do kwestii prawnych lub wątpliwości etycznych, takich jak treści związane z nielegalną bronią, narkotykami lub wrażliwymi danymi osobowymi.

- Code Shield –specjalne zabezpieczenie o nazwie Code Shield ma na celu wychwycenie i zapobieganie generowaniu niezabezpieczonego kodu, zapewniając, że każdy kod utworzony przez model jest zgodny z najlepszymi praktykami bezpieczeństwa.

- Programowalne zabezpieczenia (ang. Guardrails)– programiści mogą zdefiniować dodatkowe zabezpieczenia, aby precyzyjniej kontrolować zachowanie modelu, dostosowując wyniki sztucznej inteligencji do konkretnych przypadków użycia i zapewniając zachowanie granic etycznych.

Szczegółowy podział Guardrails

Bezpieczeństwo treści

Bezpieczeństwo treści w Llama 3 jest zarządzane za pomocą zaawansowanego systemu klasyfikacji, który wyświetla zarówno polecenia wejściowe (ang. input prompts), jak i wygenerowane odpowiedzi. System ten oznacza treści, które należą do predefiniowanych kategorii szkód, takich jak:

- Przestępstwa z użyciem przemocy – wszelkie treści, które promują, popierają lub ułatwiają przemoc wobec osób lub grup, w tym terroryzm i przestępstwa z nienawiści.

- Przestępstwa bez użycia przemocy –obejmuje to oszustwa, kradzieże i inne nielegalne działania, które nie wiążą się z bezpośrednią przemocą, ale mogą powodować znaczne szkody.

- Wrażliwe dane osobowe – chroni prywatność, zapobiegając generowaniu treści, które zawierają lub sugerują dane osobowe bez zgody.

Ograniczenia etyczne i prawne

Etyczna ochrona Llama 3 zapewnia zgodność ze standardami prawnymi i normami etycznymi. Obejmują one:

- Zakaz promowania nielegalnych działań – model jest ograniczony do generowania treści związanych z nielegalną bronią, narkotykami i innymi regulowanymi substancjami.

- Poszanowanie własności intelektualnej – zapobiega generowaniu treści naruszających prawa autorskie lub znaki towarowe.

Aby uzyskać więcej informacji na temat etycznego użytkowania, zachęcam do zapoznania się z Hugging Face’s Overview of Llama 3 i TechRepublic’s Cheat Sheet on Llama 3.

Code Shield

Code Shield to unikalna funkcja Llama 3, która koncentruje się na bezpiecznym generowaniu kodu. Skanuje i niweluje niezabezpieczone wzorce kodu, zapewniając, że każdy kod utworzony przez model jest zgodny z najlepszymi praktykami w zakresie cyberbezpieczeństwa. Jest to szczególnie ważne dla programistów, którzy mogą używać Llama 3 do generowania skryptów lub automatyzacji zadań.

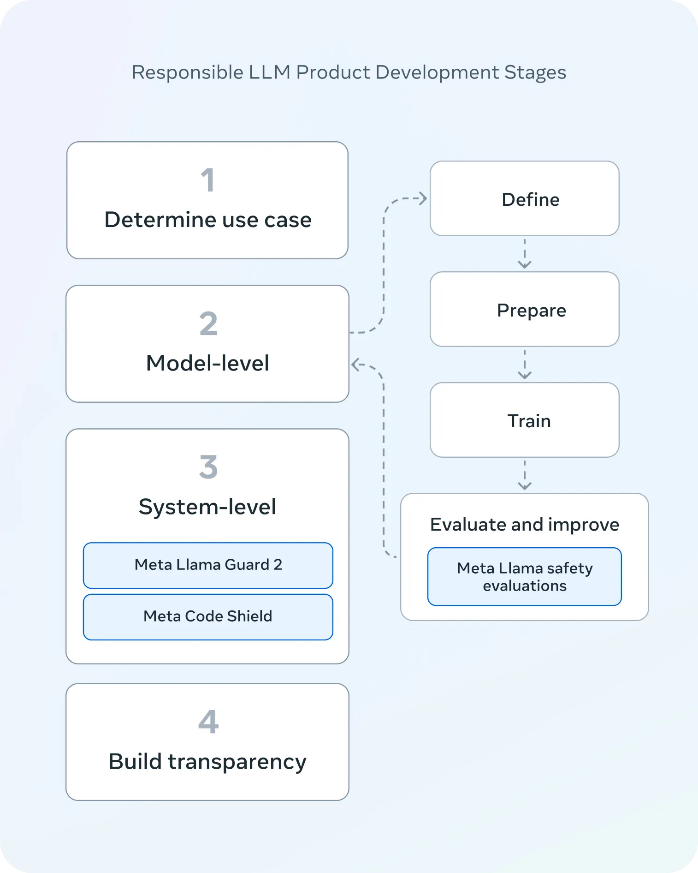

Szczegółowa analiza techniczna – wdrażanie Guardrails

Dla tych, którzy są zainteresowani techniczną implementacją, Llama 3 wykorzystuje połączenie klasyfikacji treści i filtrowania odpowiedzi w celu egzekwowania swoich zabezpieczeń. Model korzysta z zabezpieczenia znanego jako Llama Guard 2, które klasyfikuje zarówno dane wejściowe, jak i wyjściowe w celu określenia ich bezpieczeństwa.

Obejmuje to użycie progu prawdopodobieństwa dla pierwszego tokena, aby przewidzieć, czy treść jest bezpieczna. Jeśli treść zostanie uznana za niebezpieczną, jest oznaczana i odfiltrowywana. Dodatkowo, funkcja Code Shield specjalnie skanuje i łagodzi niezabezpieczone wzorce kodu, wykorzystując zaawansowane techniki sztucznej inteligencji do identyfikacji potencjalnych luk w zabezpieczeniach.

Wdrażanie Guardrails

Aby zaimplementować Guardrails, programiści mogą wykorzystać gotowe funkcje i konfigurowalne ustawienia w ramach frameworka Llama 3. Na przykład, korzystając z biblioteki transformers, programiści mogą ustawić określone parametry, aby kontrolować proces generowania:

from transformers import pipeline

import torch

model_id = "meta-llama/Meta-Llama-3-8B-Instruct"

pipe = pipeline(

"text-generation",

model=model_id,

model_kwargs={"torch_dtype": torch.bfloat16},

device="cuda",

)

messages = [

{"role": "system", "content": "You are a pirate chatbot who always responds in pirate speak!"},

{"role": "user", "content": "Who are you?"},

]

terminators = [

pipe.tokenizer.eos_token_id,

pipe.tokenizer.convert_tokens_to_ids("<|eot_id|>")

]

outputs = pipe(

messages,

max_new_tokens=256,

eos_token_id=terminators,

do_sample=True,

temperature=0.6,

top_p=0.9,

)

assistant_response = outputs[0]["generated_text"][-1]["content"]

print(assistant_response)

Więcej informacji oraz zasoby

Aby zagłębić się w techniczne aspekty i implikacje AI Guardrails, polecam kilka lektur:

- oficjalna dokumentacja Meta,

- zgłaszanie problemów z modelem,

- zgłaszanie ryzykownych treści generowanych przez model.

Jak możemy pomóc?

Guardrails są niezbędne nie tylko dla Llama, ale także dla innych modeli dostosowanych do konkretnych potrzeb i wymagań bezpieczeństwa Twojej organizacji.

Kluczowe punkty obejmują:

- Przegląd tego, czym są AI Guardrails i dlaczego są one kluczowe dla utrzymania integralności i etycznego wykorzystania systemów AI.

- Praktyczne kroki w celu zintegrowania solidnych zabezpieczeń (Guardrails) z Llama 3, zapewniając zgodność ze standardami etycznymi oraz protokołami bezpieczeństwa organizacji.

- Strategie zastosowania podobnych środków bezpieczeństwa do innych modeli AI w organizacji, podkreślające znaczenie spójnego podejścia do bezpieczeństwa AI.

- Dostosowanie zabezpieczenia AI do istniejących polityk bezpieczeństwa, aby stworzyć spójną i kompleksową strategię bezpieczeństwa.

Nadając priorytet wdrożeniu tych zabezpieczeń, możemy pomóc zapewnić, że technologie AI są wykorzystywane w sposób odpowiedzialny i bezpieczny, odzwierciedlając wartości oraz środki bezpieczeństwa firmy.

Podsumowanie

Guardrails w Llama 3 stanowią znaczący krok naprzód w zapewnianiu bezpiecznego i etycznego wykorzystania sztucznej inteligencji. Ponieważ technologie te nadal ewoluują, nie można przecenić znaczenia solidnych zabezpieczeń. Rozumiejąc i wdrażając te zabezpieczenia, możemy wykorzystać moc sztucznej inteligencji, jednocześnie minimalizując związane z nią ryzyko, czyniąc ją cennym narzędziem zarówno dla programistów, jak i użytkowników.

Zachęcam do podzielenia się Waszymi przemyśleniami i doświadczeniami z Llama 3 w komentarzach poniżej. Kontynuujmy rozmowę o przyszłości bezpiecznej i etycznej sztucznej inteligencji!

Zostaw komentarz