W ostatnich latach Machine Learning (ML) zyskał na popularności i stał się nieodzownym narzędziem w wielu branżach. Jednak samo stworzenie modelu ML to tylko część sukcesu. Kluczowe jest również jego wdrożenie, zarządzanie i utrzymanie w środowisku produkcyjnym.

I tutaj na scenę wkracza MLOps, czyli zestaw praktyk, które umożliwiają efektywne zarządzanie cyklem życia modeli ML.

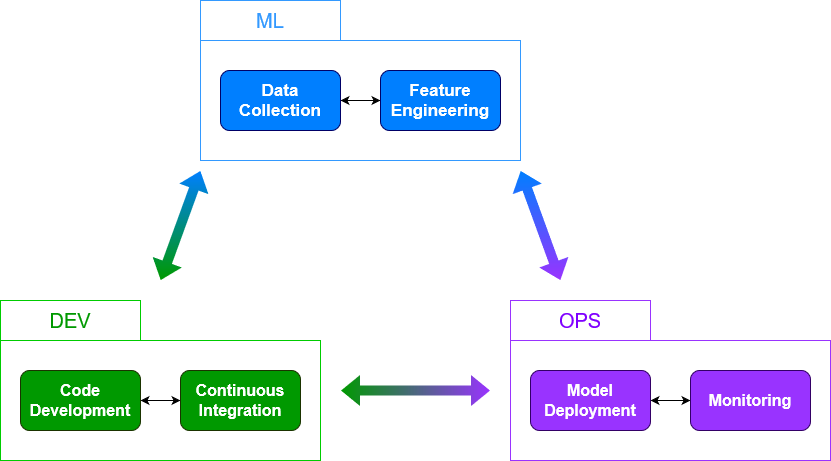

MLOps, skrót od Machine Learning Operations, łączy elementy DevOps, Data Engineering i Machine Learning w jeden spójny proces. Dzięki temu możliwe jest nie tylko szybkie i efektywne tworzenie modeli, ale także ich ciągłe dostarczanie oraz monitorowanie. MLOps pomaga zespołom ML skupić się na tworzeniu wartościowych modeli, podczas gdy automatyzacja kontroluje operacyjne aspekty ich wdrażania i utrzymania.

Na czym polega MLOps, czym różni się od DevOps i dlaczego jest kluczowy dla sukcesu projektów ML? Odpowiedzi na te pytania znajdziesz w dalszej części artykułu.

Definicja i najważniejsze pojęcia

MLOps to praktyki i narzędzia, które wspierają zarządzanie cyklem życia modeli ML. Obejmują elementy od pozyskiwania danych, przez trening modeli, aż po ich wdrożenie i monitorowanie. Automatyzacja jest tutaj kluczowa, ponieważ umożliwia szybkie i powtarzalne procesy, co jest niezbędne w szybko zmieniających się środowiskach.

DevOps skupia się na automatyzacji i optymalizacji procesów dostarczania oprogramowania.

MLOps rozszerza te koncepcje na specyficzne potrzeby projektów ML, które uwzględniają:

- zarządzanie danymi,

- trening modeli,

- ocenę ich wydajności,

- ciągłe monitorowanie.

Podczas gdy DevOps koncentruje się na kodzie, MLOps kładzie nacisk na dane i modele, które są sercem każdego projektu ML.

Z czego składa się MLOps?

Continuous Integration i Continuous Delivery

Continuous Integration (CI) to praktyka regularnego integrowania zmian w kodzie do wspólnego repozytorium. W kontekście MLOps CI nie ogranicza się jedynie do kodu, ale obejmuje również dane i modele. Dzięki CI możliwe jest szybkie wykrywanie błędów oraz utrzymanie wysokiej jakości całego projektu ML.

W procesie CI możemy wyróżnić takie składowe jak:

- automatyczne testowanie kodu – każda zmiana w kodzie jest automatycznie testowana, co pozwala na wczesne wykrycie błędów,

- integrowanie danych – nowe dane są regularnie integrowane i testowane, aby zapewnić ich jakość i spójność,

- integrowanie modeli – nowe wersje modeli są regularnie wdrażane do środowiska testowego, co umożliwia ich bieżącą ocenę.

Continuous Delivery (CD) to praktyka automatycznego wdrażania nowych wersji oprogramowania do środowiska produkcyjnego. W MLOps CD oznacza automatyczne wdrażanie modeli ML do produkcji, co pozwala na szybkie reagowanie na zmieniające się warunki biznesowe i potrzeby użytkowników.

Warto zauważyć, że popularną i nieco nieoczywistą praktyką jest testowanie w środowisku produkcyjnym – modele są testowane w środowisku produkcyjnym przed pełnym wdrożeniem, co pozwala na wykrycie potencjalnych problemów. Każde wdrożenie jest oczywiście monitorowane, aby zapewnić jego prawidłowe działanie i szybko reagować na ewentualne problemy.

Continuous Training i Continuous Monitoring

Continuous Training (CT) to praktyka regularnego trenowania modeli na nowych danych. Dzięki CT modele są stale aktualizowane, a to zapewnia ich wysoką jakość i aktualność w obliczu zmieniających się danych wejściowych. Oprócz tego, ważnym aspektem jest zarządzanie danymi treningowymi, a ich regularne aktualizowanie i testowanie zapewnia jakość oraz spójność.

Na koniec oczywiście należy również przetestować same modele. Nowe wersje są automatycznie testowane, co pozwala na ich ocenę i wybór najlepszej wersji do wdrożenia.

Continuous Monitoring (CM) to proces ciągłego monitorowania wydajności modeli po ich wdrożeniu. Pozwala na szybkie wykrywanie problemów, takich jak spadek dokładności modelu, co jest kluczowe dla utrzymania wysokiej jakości systemu. Metryki wydajności, do których należą dokładność, precyzja, recall są stale kontrolowane, aby zapewnić wysoką jakość modeli. Automatyczne wykrywanie anomalii w danych lub wydajności modeli pozwala na szybkie reagowanie na problemy.

Na końcu aktualizacje i utrzymanie modeli pozwalają zapewnić ich ciągłą wysoką jakość i niezawodność.

MLOps w praktyce

Z pewnością wiesz, jak ważna jest efektywna automatyzacja, kontrola wersji oraz monitoring i maintenance w kontekście nie tylko ML, ale budowaniu systemów w ogóle. Te trzy kluczowe elementy pozwalają na skuteczne zarządzanie procesami związanymi z ML. Przejdźmy zatem do szczegółów.

Automatyzacja pipelinów

Automatyzacja pipelinów jest jednym z najistotniejszych elementów MLOps. Wyobraź sobie, że musisz ręcznie przeprowadzać każdy etap tworzenia modelu – od zbierania danych, przez trenowanie, aż po wdrożenie. Byłoby to nie tylko czasochłonne, ale i podatne na błędy. Automatyzacja pipelinów pozwala na zautomatyzowanie tych kroków, dzięki czemu proces staje się szybszy i bardziej spójny. Dodatkowo, automatyzacja umożliwia łatwiejsze skalowanie, co jest nieocenione w dużych projektach.

Kontrola wersji

Kontrola wersji w MLOps jest równie istotna jak w tradycyjnym programowaniu. Dzięki niej możemy śledzić zmiany w kodzie, danych oraz modelach, co jest kluczowe dla zachowania spójności i reprodukcji wyników. Bez kontroli trudno byłoby odtworzyć wcześniejsze wersje modelu czy zrozumieć, jakie zmiany doprowadziły do konkretnych wyników. Narzędzia takie jak Git są powszechnie stosowane w tym kontekście, ale dodatkowo warto rozważyć specjalistyczne rozwiązania do kontroli wersji danych i modeli, jak np.: DVC (Data Version Control).

Monitoring i maintenance

Monitoring i maintenance to aspekty, które często są niedoceniane, a jednak mają ogromne znaczenie w kontekście MLOps. Nawet najlepiej stworzony model może z czasem stracić na jakości, jeśli nie będzie odpowiednio monitorowany. Regularny monitoring pozwala na wykrywanie driftu danych oraz zmian w wydajności modelu. Co więcej, dzięki odpowiednim narzędziom monitorującym możemy szybko reagować na wszelkie nieprawidłowości, zapewniając ciągłość działania systemu. Maintenance z kolei oznacza regularne aktualizacje modeli i danych, aby były bieżące i jak najbardziej efektywne.

Jak Azure ML wspiera MLOps?

Azure ML oferuje szereg funkcji i narzędzi wspierających implementację MLOps, dzięki czemu możemy efektywnie zarządzać cyklem życia modeli ML.

Funkcje

- Automatyzacja pipeline’ów CI/CD to jedna z kluczowych funkcji Azure ML. Dzięki niej możemy automatyzować procesy trenowania, testowania oraz wdrażania modeli. Integracja z Azure DevOps pozwala na płynne zarządzanie tymi procesami, co znacząco zwiększa efektywność pracy zespołów ML.

- Kontrola wersji i śledzenie eksperymentów to kolejny istotny element. Platforma zapewnia mechanizmy do wersjonowania kodu, danych oraz modeli, ułatwiając monitorowanie wyników i zapewniając audytowalność. Dzięki temu możemy w prosty sposób porównywać różne eksperymenty i wybierać najlepsze modele.

- Bezpieczeństwo i zgodność danych oraz modeli są również kluczowe w Azure ML. Platforma dba o zaawansowane mechanizmy autoryzacji i uwierzytelniania, dzięki czemu możemy być pewni, że nasze dane oraz modele są odpowiednio chronione.

- Wdrażaniu modeli – Azure ML pozwala na uruchamiane modeli w chmurze, co upraszcza wdrażanie ich jako usługi webowej na platformach takich jak Azure Kubernetes Service (AKS) czy Azure Container Instances (ACI). Dzięki temu możemy szybko udostępnić nasz model do produkcji. Co więcej, narzędzia do monitorowania i skalowania wdrożonych modeli zapewniają ich wydajność i niezawodność.

- Zarządzanie danymi – platforma integruje się z różnymi źródłami danych, umożliwiając ich wersjonowanie, co jest kluczowe dla odtwarzalności wyników eksperymentów. Dodatkowo, obsługuje przetwarzanie danych poprzez integrację z usługami takimi jak Azure Data Factory czy Azure Databricks, co pozwala na kompleksowe przetwarzanie danych na potrzeby uczenia maszynowego.

Narzędzia

- Narzędzia do monitorowania i zarządzania modelami w produkcji – monitorowanie wydajności modeli w czasie rzeczywistym pozwala na szybkie reagowanie na ewentualne problemy oraz zapewnienie, że modele działają zgodnie z oczekiwaniami. Integracja z narzędziami do monitorowania, takimi jak Azure Monitor, ułatwia śledzenie kluczowych metryk.

- Narzędzia do zarządzania eksperymentami, dzięki którym możemy definiować i zarządzać pipeline’ami trenowania modeli, śledzić przebieg eksperymentów, porównywać wyniki i wybierać najlepsze modele do wdrożenia. Platforma umożliwia także rejestrowanie modeli, co ułatwia ich wersjonowanie oraz zarządzanie cyklem życia.

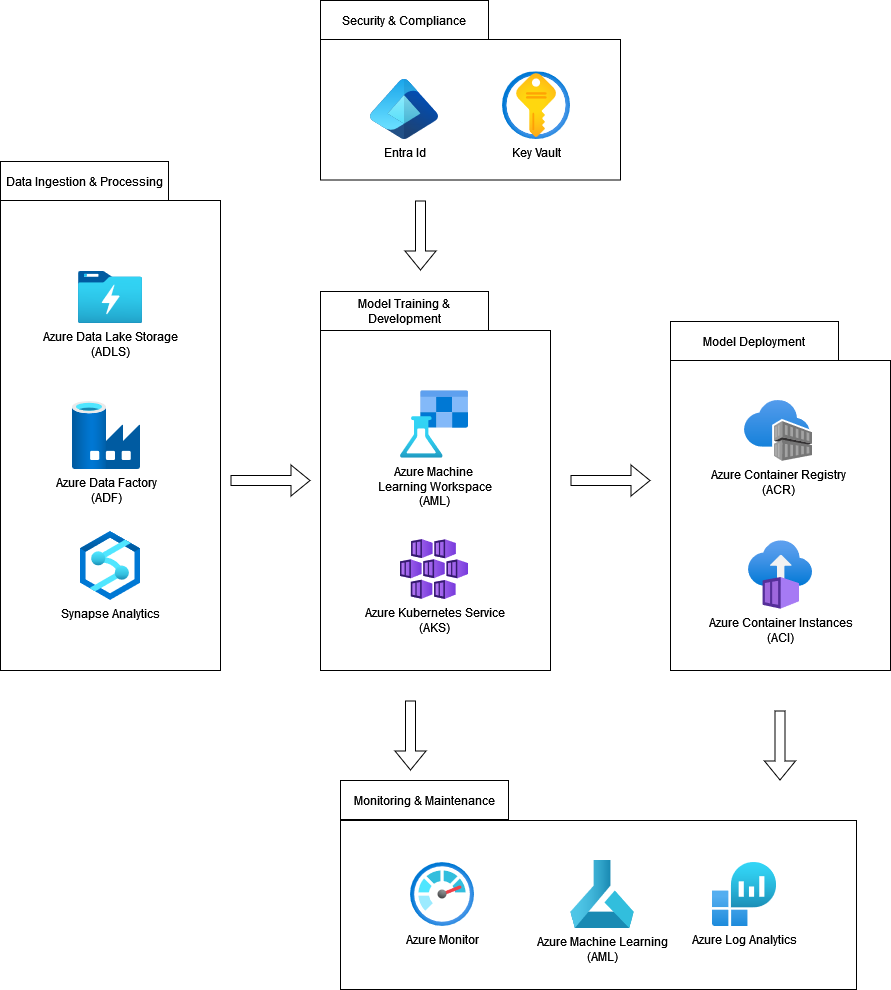

Typowa architektura MLOps oparta o Azure ML i inne usługi Azure

Wdrażanie MLOps w praktyce wymaga solidnej architektury, która integruje różne narzędzia i usługi w spójny proces. W kontekście Azure, typowa architektura MLOps opiera się na szeregu usług, które wspierają cały cykl życia modeli ML – od przetwarzania danych, przez trening i wdrażanie modeli, aż po ich monitorowanie i zarządzanie.

Przeanalizujmy przykładową architekturę MLOps opartą na Azure ML, wzbogaconą o komplementarne usługi Azure.

Początek procesu

Cały proces rozpoczyna się od zbierania i przetwarzania danych. Azure Data Lake Storage (ADLS) pełni funkcję centralnego repozytorium, gdzie przechowywane są zarówno surowe, jak i przetworzone dane. Ta elastyczna przestrzeń do przechowywania danych umożliwia ich efektywne zarządzanie oraz szybki dostęp w późniejszych etapach.

Do automatyzacji procesu ekstrakcji, transformacji i ładowania danych (ETL) wykorzystuje się Azure Data Factory (ADF), które integruje dane z różnych źródeł, zapewniając ich spójność i przygotowanie do dalszego przetwarzania. Na tym etapie wkracza również Azure Synapse Analytics, który jako zintegrowana platforma analityczna umożliwia złożone przetwarzanie danych oraz przygotowanie ich do treningu modeli ML.

Trening modeli i wdrożenie

Gdy dane są już gotowe, przystępujemy do treningu modeli. Kluczową rolę odgrywa tutaj Azure Machine Learning (AML) Workspace, które jest centralnym miejscem zarządzania całym procesem ML. W AML Workspace można zarządzać eksperymentami, trenować modele, a także kontrolować wersje kodu, danych i modeli. W przypadku bardziej złożonych obliczeń, wymagających większej mocy, trening modeli można skalować za pomocą Azure Kubernetes Service (AKS). AKS umożliwia równoczesne przetwarzanie wielu eksperymentów i modeli, co jest niezbędne w dużych projektach ML.

Po zakończeniu treningu modelu, kolejnym krokiem jest jego wdrożenie do środowiska produkcyjnego. Azure Container Registry (ACR) przechowuje obrazy kontenerów Docker, które mogą być wykorzystywane do tego zadania. Wdrażanie odbywa się na Azure Kubernetes Service (AKS) lub Azure Container Instances (ACI), co umożliwia łatwe uruchamianie modeli jako kontenerów. Dzięki tej elastycznej infrastrukturze, modele mogą być skalowane w zależności od obciążenia i udostępniane jako usługi webowe. Pozwala to łatwo integrować wyniki modeli z aplikacjami biznesowymi.

Kolejne kroki

Kiedy modele działają już w środowisku produkcyjnym, niezbędne jest ich monitorowanie i zarządzanie. Azure Monitor pozwala monitorować wydajnoścć modeli w czasie rzeczywistym, umożliwiając śledzenie kluczowych metryk, wykrywanie anomalii oraz generowanie alertów w przypadku problemów. Dane logów zbierane z różnych usług są analizowane za pomocą Azure Log Analytics, co pozwala na kompleksową diagnostykę i monitorowanie systemów ML.

Azure Machine Learning (AML) wspiera również zarządzanie cyklem życia modeli. Pozwala na ich wersjonowanie, monitorowanie wydajności oraz automatyczne retraining w odpowiedzi na zmieniające się dane.

Ostatecznym, lecz równie istotnym, elementem architektury MLOps jest zapewnienie bezpieczeństwa i zgodności z wymaganiami regulacyjnymi. Azure Active Directory (AAD) zarządza dostępem i uprawnieniami do zasobów Azure, co chroni przed nieautoryzowanym dostępem. Dodatkowo, Azure Key Vault umożliwia bezpieczne przechowywanie kluczy, tajemnic i certyfikatów, chroniąc wrażliwe dane używane w procesach ML.

Przepływ danych i procesów w tej architekturze jest płynny i dobrze zintegrowany. Dane najpierw trafiają do Azure Data Lake Storage, gdzie są przechowywane, a następnie przetwarzane przez Azure Data Factory i Synapse Analytics i wykorzystywane do trenowania modeli w Azure ML Workspace. Tam zarządza się eksperymentami i wersjami modeli.

Na koniec

Po przeszkoleniu, modele są wdrażane na AKS lub ACI, a następnie monitorowane przez Azure Monitor i Log Analytics. Ich cały cykl życia jest zarządzany w sposób bezpieczny i zgodny z wymaganiami dzięki usługom AAD i Key Vault.

Taka architektura nie tylko wspiera wszystkie etapy procesu MLOps, ale także zapewnia elastyczność, skalowalność i bezpieczeństwo, które są kluczowe w nowoczesnych projektach ML.

Podsumowanie

MLOps to kluczowy element nowoczesnych projektów związanych z uczeniem maszynowym, umożliwiający skuteczne zarządzanie całym cyklem życia modeli ML. Dzięki praktykom takim jak: automatyzacja pipelinów, kontrola wersji, monitoring i utrzymanie, zespoły mogą nie tylko tworzyć modele, ale również zapewniać ich ciągłą aktualizację i monitorowanie w środowisku produkcyjnym.

Azure, a szczególnie Azure Machine Learning (AML), oferuje zestaw narzędzi i usług, które integrują się w ramach MLOps, wspierając wszystkie etapy pracy z modelami ML. Usługi takie jak Azure Data Lake Storage, Azure Synapse Analytics, czy Azure Kubernetes Service pozwalają na zbudowanie kompleksowej architektury, która jest elastyczna, skalowalna i dostosowana do potrzeb współczesnych projektów ML.

Wdrożenie MLOps na platformie Azure pozwala na efektywne zarządzanie modelami ML, od pozyskiwania i przetwarzania danych, przez trening i wdrażanie modeli, aż po ich monitorowanie i utrzymanie. Dzięki temu, organizacje mogą szybciej reagować na zmieniające się dane i wymagania, zapewniając, że ich modele są zawsze aktualne i działają zgodnie z oczekiwaniami. Azure ML, jako platforma, dostarcza narzędzi, które ułatwiają te procesy, czyniąc je bardziej efektywnymi i spójnymi.

Taka infrastruktura nie tylko wspiera realizację bieżących projektów, ale także tworzy solidną podstawę do przyszłego rozwoju w dziedzinie uczenia maszynowego.

***

Jeśli interesuje Cię tematyka Azure, zajrzyj koniecznie do innych artykułów naszych ekspertów 🙂

Zostaw komentarz