Artykuł skierowany jest do osób początkujących oraz bardziej doświadczonych w obszarze sieci neuronowych. Ma na celu w uproszczony sposób wprowadzić Was w dwa przykładowe modele danych i zainspirować do dalszych doświadczeń z sieciami neuronowymi. Treść przybliży nam ich ogólne działanie. Przedstawione zostaną sposoby uczenia modeli sieci neuronowych służące do przewidywania przyszłych danych, jak również sposoby przygotowania tych modeli w języku Python.

Sieci neuronowe są jednym z najbardziej popularnych narzędzi w dziedzinie analizy danych i predykcji. Omawiane modele – GRU (ang. Gate Recurrent Unit) i LSTM (ang. Long Short-Term Memory) – są rodzajami sieci neuronowych, które są szczególnie skuteczne w analizie sekwencji danych. Oba modele mają zdolność do przechowywania informacji przez dłuższy czas, co jest kluczowe w analizie sekwencji, takich jak serie czasowe.

Do czego służy sieć neuronowa i jak działa?

Sieć neuronowa jest algorytmem uczenia maszynowego, który wykorzystuje połączone ze sobą neurony do przetwarzania informacji i wykonywania predykcji. Neurony nie podejmują decyzji, ale aktywują się lub nie na podstawie wejściowych danych i wag, które są dostosowywane podczas uczenia.

Sieci neuronowe są stosowane w wielu dziedzinach, takich jak:

- rozpoznawanie obrazów,

- analiza tekstu,

- predykcja sekwencji

- i wiele innych.

Podczas działania, wejściowe dane są przetwarzane przez warstwy neuronów, a wynik jest zwracany przez warstwę wyjściową. Podczas uczenia, sieć neuronowa dostosowuje wagi między neuronami, aby zminimalizować błąd predykcji.

Z jakich danych najlepiej korzystać i jak je przygotować?

Aby zapewnić jak najwyższą skuteczność modelu, dane wykorzystywane w sieciach neuronowych powinny być odpowiednio przygotowane. Dla modeli GRU i LSTM, by uzyskać najlepsze wyniki, powinniśmy wykorzystać dane sekwencyjne, takie jak serie czasowe, gdzie każdy punkt danych jest zależny od poprzedniego. Dane powinny być uporządkowane w sekwencje, a następnie podzielone na zbiory: treningowy, walidacyjny i testowy.

Skalowanie danych jest ważnym etapem ich przygotowania przed trenowaniem sieci neuronowej. Zrobienie tego do określonego zakresu, np. do wartości między 0 a 1, może pomóc znormalizować wartości wejściowe i poprawić wydajność sieci neuronowej. Ponadto, skalowanie danych może pomóc w zmniejszeniu wpływu wartości odstających, które mogą negatywnie oddziaływać na proces uczenia i predykcji sieci neuronowej.

Czym charakteryzują się modele GRU i LSTM?

Modele GRU i LSTM składają się z komórek pamięci, które umożliwiają sieci neuronowej przechowywanie informacji przez dłuższy czas. Komórki te potrafią kontrolować, które informacje są gromadzone, a które są ignorowane.

W modelu LSTM, komórki pamięci są kontrolowane przez trzy bramki:

- bramkę wejściową – weryfikuje, które informacje powinny być przechowywane,

- bramkę wyjściową – kontroluje, które informacje powinny być uwzględnione w wyniku sieci,

- bramkę zapomnienia – pozwala sieci na zapominanie niepotrzebnych informacji.

W modelu GRU, bramki są uproszczone do:

- bramki resetu – odpowiada za kontrolę, które informacje powinny być zapomniane,

- bramki aktualizacji – odpowiada za kontrolę, które informacje powinny być uwzględnione w wyniku sieci.

Modele GRU są zazwyczaj mniej złożone niż modele LSTM i mają tendencję do szybszego uczenia się.

Jak uczymy te modele i jak to wszystko działa?

Modele GRU i LSTM uczą się poprzez minimalizowanie błędu predykcji. Proces uczenia składa się z dwóch etapów:

- propagacji w przód,

- propagacji wstecznej.

W propagacji w przód dane wejściowe są przetwarzane przez warstwy neuronów, a następnie przekazywane do warstwy wyjściowej, która zwraca wynik. W propagacji wstecznej błąd predykcji jest propagowany wstecz przez sieć neuronową, a następnie aktualizowane są wagi między neuronami.

Uczenie modeli GRU i LSTM jest często trudne i wymaga odpowiedniego doboru hiperparametrów, takich jak:

- liczba warstw,

- liczba neuronów w każdej warstwie,

- współczynnik uczenia i wiele innych.

Przykład analizy

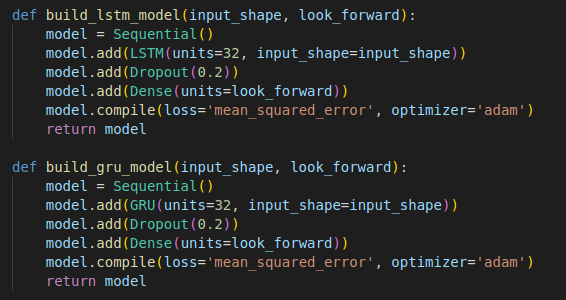

Podczas mojej analizy tych modeli został wykorzystany język Python i biblioteka tensorflow.

- input_shape – kształt wejściowego tensora danych – odpowiada kształtowi naszych danych testowych i przygotowanych danych w celu uczenia modelu sieci neuronowej,

- look_forward – liczba kroków czasowych, na które model ma przewidywać wartości w przyszłości,

- dropout – technika regularyzacji, która losowo usuwa pewien procent neuronów w warstwie podczas treningu,

- units – określa liczbę ukrytych neuronów w warstwie rekurencyjnej sieci,

- dense – to liczba neuronów w warstwie gęstej,

- loss – funkcja straty, która określa jak bardzo predykcje modelu różnią się od rzeczywistych wartości,

- optimizer – określa metodę optymalizacji, którą sieć neuronowa będzie stosować podczas treningu.

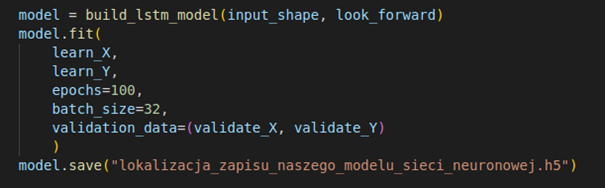

Gdybyśmy chcieli wybudować i zapisać nasz model do pliku w celu używania go po wyuczeniu, powiniśmy wykonać dodatkowo poniższy kod:

- learn_X i learn_Y – dane treningowe,

- validate_X i validate_Y – dane walidacyjne,

- epochs – liczba epok, czyli przejść przez cały zbiór treningowy,

- batch_size – liczba próbek użytych do jednej aktualizacji wag.

Jak używać danych z nauczonych modeli i jakie możemy osiągnąć prawdopodobieństwo danych?

Po nauczeniu modelu GRU lub LSTM można go wykorzystać do predykcji kolejnych punktów sekwencji np. do przewidywania przyszłych wartości serii czasowej na podstawie danych historycznych.

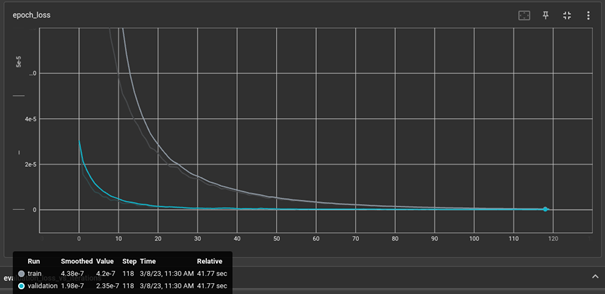

Prawdopodobieństwo predykcji można określić na podstawie błędu predykcji. Im mniejszy błąd, tym większe prawdopodobieństwo, że predykcja jest poprawna.

Obraz został wygenerowany poprzez narzędzie tensorboard.

W jakich sytuacjach powinniśmy ulepszać nasz model sieci neuronowej i jak możemy to robić?

Przykładowe sytuacje, w których powinniśmy zastanowić się nad ulepszeniem naszego modelu sieci neuronowej:

- model sieci neuronowej nie osiąga pożądanych wyników lub występuje niska skuteczność wyników,

- jeśli model osiąga bardzo dobre wyniki na danych treningowych, ale słabe na danych testowych,

- pojawią się nowe dane, które są różne od tych, na których model był uczony,

- model działa poprawnie, ale nie jest wystarczająco szybki lub wydajny,

- struktura danych wejściowych została zmieniona lub chcemy otrzymywać inne dane.

Aby ulepszyć model sieci neuronowej, można zastosować różne techniki takie jak:

- dodanie dodatkowych warstw neuronów,

- zwiększenie liczby neuronów w każdej warstwie,

- dostosowanie hiperparametrów, takich jak współczynnik uczenia i liczba epok,

- wykorzystanie technik regularyzacji takich jak dropout, aby zapobiec przeuczeniu modelu,

- ulepszanie danych wejściowych np. poprzez zastosowanie technik normalizacji lub transformacji danych.

Podsumowanie

Modele GRU i LSTM służą analizie sekwencji danych, takich jak serie czasowe. Aby osiągnąć jak najlepsze wyniki, należy odpowiednio przygotować dane i dostosować hiperparametry modelu. Po jego wytrenowaniu, można go wykorzystać do predykcji kolejnych punktów sekwencji.

Aby ulepszyć model, powinniśmy zastosować różne techniki, takie jak dodanie dodatkowych warstw, regularyzacja czy ulepszanie danych wejściowych. Ważne jest również, aby unikać przeuczenia modelu i stosować techniki regularyzacji np. dropout, w celu zapobiegania zbytniemu dopasowaniu do danych treningowych.

Wreszcie, warto pamiętać, że modele GRU i LSTM są jedynie narzędziami, a jakość wyników będzie zależała od jakości danych wejściowych i odpowiedniego wykorzystania modelu w kontekście konkretnego problemu.

Przydatne linki

- TensorFlow – biblioteka, która umożliwia nam procesowanie sieci neuronowych.

- Keras – zestaw modeli danych przydatnych w uczeniu maszynowym, biblioteka ta jest używana w Pythonie.

- Sklearn preprocessing – bibloteka dla Pythona, która w szybki sposób umożliwia nam przygotowanie danych do normalizacji jak również zdenormalizowanie danych po predykcji.

***

Jeśli interesuje Cię tematyka uczenia maszynowego, zajrzyj również do innych artykułów naszych ekspertów.

Zostaw komentarz