W artykule zaprezentuję Stable Diffusion – innowacyjny model generowania obrazów z 2022 roku, który w „magiczny” sposób zmienia opisy tekstowe w wizualizacje. Przedstawię ogólny zarys działania narzędzia, przeanalizuję jego wykorzystanie w różnych kontekstach – między innymi wskażę korzyści płynące z funkcji „negatywnego promptu”, opiszę też, jak dobrać poszczególne parametry przy generowaniu obrazu.

Mam nadzieję, że artykuł będzie interesujący nie tylko dla profesjonalistów związanych z technologiami AI, ale także dla artystów, grafików, developerów gier, a także dla każdej osoby pasjonującej się rozwiązaniami technologicznymi. Niezależnie od poziomu wiedzy na temat głębokiego uczenia się sieci neuronowych, gwarantuję, że w artykule znajdą się ciekawostki oraz wartościowe informacje, które pozwolą lepiej zrozumieć i docenić fenomen Stable Diffusion.

Czym jest Stable Diffusion?

Stable Diffusion to model opracowany przez innowacyjny start-up Stability AI. Ma on szerokie zastosowanie – od generowania szczegółowych wizualizacji po uzupełnianie brakujących fragmentów obrazów czy kreowanie tła, a nawet tworzenie kierowanych tekstem przeobrażeń obrazu w obraz.

Co istotne, Stability AI jest przyjazny dla społeczności open source i udostępniło kod źródłowy Stable Diffusion oraz wagi modeli dla każdego, kto ma umiarkowane GPU z co najmniej 8 GB VRAM.

Stable Diffusion wykorzystuje latent diffusion model (LDM), opracowany przez naukowców z grupy CompVis na Uniwersytecie Ludwika i Maksymiliana w Monachium. Początkowo modele dyfuzji, które powstały w 2015 roku, były szkolone tak, aby usuwały szum z obrazów szkoleniowych. Model Stable Diffusion jest jednak bardziej wyszukany, ponieważ potrafi na podstawie opisu przekształcić całkowicie zaszumiony zbiór pikseli w sensowny i atrakcyjny obraz.

Ograniczenia Stable Diffusion

Jednakże, jak to często bywa, każda technologia ma swoje wady, a Stable Diffusion nie jest tu wyjątkiem.

Pierwszym ograniczeniem jest rozdzielczość generowanych obrazów – dla modeli 1.4 i 1.5 wynosi ona jedynie 512 x 512 pikseli, co jest znacznie mniejszą rozdzielczością niż oferują konkurencyjne, aczkolwiek płatne, rozwiązania, takie jak Dalle-2 czy Midjurney. W wersji 2.0 i 2.1 istnieje możliwość generowania obrazów w rozdzielczości 768×768 pikseli. W teorii, możliwe jest zapytanie Stable Diffusion o wygenerowanie obrazu w większej rozdzielczości, jednakże wynik może okazać się karykaturalny.

Poniżej znajduje się przykład obrazu o rozdzielczości 1024×512. Ze względu na użycie zbyt dużej rozdzielczości generowania doszło do duplikacji lampy i monitora.

Kolejnym częstym problemem jest generowanie obrazu poprawnych anatomicznie części ciała. Dłonie rzadko kiedy posiadają dokładnie pięć palców. Pojawia się zbyt duża liczba zębów, a twarze, jeśli jest ich więcej lub znajdują się na dalszym planie, są zdeformowane. Można by rzec, że Sztuczna Inteligencja jest wręcz sławna z tego, jak źle radzi sobie z dłońmi, czego przykład znajdziecie poniżej.

Z pomocą w tych niedostatkach muszą przyjść inne sieci neuronowe wytrenowane w zwiększaniu rozdzielczości obrazów oraz w naprawianiu uszkodzonych zdjęć, co okazało się przydatne przy naprawianiu zdeformowanych twarzy wygenerowanych ludzi. Najtrudniej jednak poradzić sobie z nadmiarowymi palcami, zębami czy całymi kończynami. Tu pomóc mogą negatywne parametry i własne modele o czym będzie w dalszej części artykułu.

Możliwości oferowane przez Stable Diffusion

Pomimo pewnych wad, Stable Diffusion oferuje użytkownikom wiele możliwości. Można wygenerować zupełnie nowy obraz na podstawie opisu, a także skorzystać z bardziej zaawansowanych technik, takich jak generowanie obrazu na podstawie innego obrazu. Możliwe jest także udoskonalenie szkiców za pomocą SD i wzbogacenie ich o nowe detale.

Oferowane funkcje obejmują również edycję istniejących obrazów, w tym wymazywanie, zmianę lub dodawanie elementów do zdjęć oraz tzw. „out painting”, czyli generowanie elementów poza kadrem edytowanego obrazu na podstawie opisu. Istotne jest to, że zarówno nowe elementy spoza kadru, jak i te dodawane wewnątrz obrazu, zazwyczaj pozostają zgodne ze stylem oryginalnego obrazu.

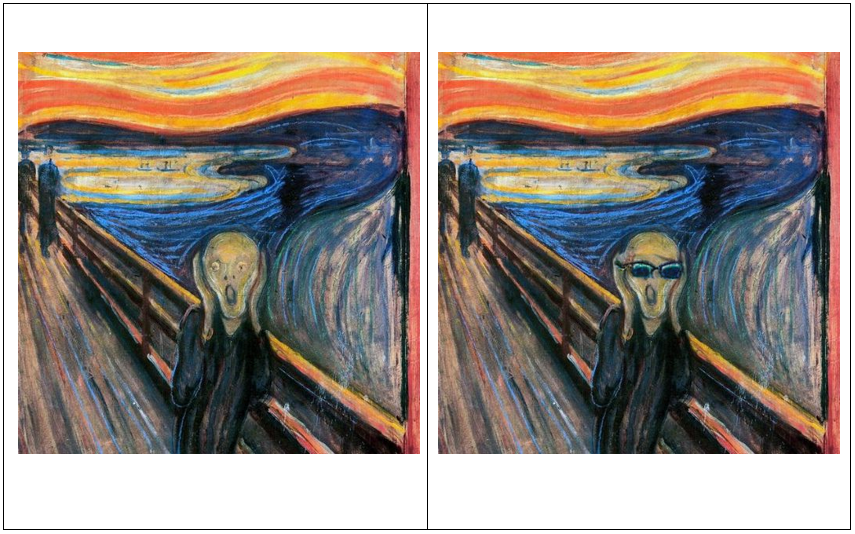

Przykład inpaintingu znanego obrazu znajdziecie niżej. W typ wypadku domalowano okulary.

Jak działa Stable Diffusion?

Warto przybliżyć mechanizm działania modeli dyfuzji, które dążą do zwiększenia precyzji generowanych obrazów.

Przed wprowadzeniem modeli dyfuzji do generowania obrazów stosowano generatywne sieci przeciwnych (ang. GANs). Składają się one z generatora i dyskryminatora, które współpracują ze sobą, by uzyskać jak najlepszy efekt. Jednak GANs mają swoje wady – są trudne do trenowania oraz często generują obrazy z niepożądanymi szczegółami.

W modelach dyfuzji skupiamy się na usuwaniu szumu z obrazu, zaczynając od dodawania iteracyjnego szumu gaussowskiego. Następnie uczymy sieć neuronową stopniowo usuwać ten szum. Szczególną uwagę należy zwrócić na wykorzystanie danych tekstowych, które kierują sieć w generowaniu pożądanych obrazów. Kluczową technologią w tym procesie jest tzw. „bezklasyfikatorowe kierowanie” (ang. classifier-free guidance), które wzmacnia wpływ danych tekstowych na generowanie obrazów.

Po wprowadzeniu odpowiedniej ilości szumu i podaniu tekstu do sieci można rozpocząć proces estymowania szumu. Wszystko odbywa się w sposób iteracyjny, co oznacza, że z każdą kolejną iteracją otrzymujemy coraz lepsze rezultaty.

Działanie wspomnianych modeli dyfuzji opiera się na procesie dwukierunkowym. W pierwszym etapie dodawane jest coraz więcej szumu do wyjściowej próbki danych, zbliżając je do postaci isotropowej. Kolejno następuje proces odwrotny, który ma na celu odtworzenie oryginalnych próbek danych bez szumów. Wykorzystywana jest wariantowa granica dolna (ang. variational lower bound), co pozwala na lepsze dopasowania modelu dyfuzji.

Bardzo istotny w całym procesie jest także związek z sieciami NCSN (ang. Noise-Conditioned Score Networks), których rola polega na szacowaniu gradientów rozkładu danych. Działanie modeli dyfuzji może być również optymalizowane poprzez zastosowanie różnych architektur i technik, takich jak U-Net (rodzaj architektury sieci neuronowej), gdzie odpowiednie parametry trwania procesu pozwalają na szybsze generowanie obrazów bez utraty jakości.

W celu generowania wysokiej jakości obrazów o dużej rozdzielczości w dyfuzji są stosowane różne modyfikacje architektury oraz ulepszenia algorytmów. Dołączanie warstw warunkujących nałożonych kolejno zapewnia lepsze wyniki, przewyższając tradycyjne modele generatywne, takie jak GANs.

Dostosowywanie modelu – fine-tuning

Aby przystosować model Stable Diffusion do różnych zastosowań, można wykorzystać proces doprecyzowywania, czyli fine-tuning. Istnieją różne metody pozwalające dostosować generowane obrazy do konkretnych potrzeb. Należą do nich m.in.: trening embeddings na podstawie własnych obrazów, użycie hypernetwork lub korzystanie z modelu DreamBooth.

W celu przeciwdziałania ograniczeniom wynikającym z początkowego treningu modelu (między innymi wspomniane wcześniej karykaturalne twarze, dłonie czy zęby), użytkownicy końcowi mogą zdecydować się na dodatkowe szkolenie w celu doprecyzowania wygenerowanych obrazów do bardziej konkretnych przypadków użycia.

Istnieją trzy metody, dzięki którym użytkownik może dostosować daną wersję modelu Stable Diffusion, korzystając z metody fine-tuning. Przybliżę je poniżej.

Embedding

Embedding może być nauczony ze zbioru obrazów dostarczonych przez użytkownika, co pozwala modelowi generować wizualnie podobne obrazy za każdym razem, gdy nazwa embeddingu jest używana w poleceniu generowania. Są one oparte na koncepcji „tekstowej inwersji” opracowanej w 2022 roku przez naukowców z Uniwersytetu Telawiwskiego przy wsparciu Nvidii. W koncepcji wektorowe reprezentacje poszczególnych tokenów używanych przez enkoder tekstu modelu są powiązane z nowymi pseudo-słowami. Embeddingi mogą być używane między innymi do naśladowania różnych stylów wizualnych.

Hypernetwork

Hypernetwork to niewielka, wytrenowana sieć neuronowa, która jest stosowana w różnych miejscach większej sieci neuronowej. Termin ten odnosi się do techniki stworzonej przez dewelopera NovelAI Kurumuza w 2021 roku, pierwotnie przeznaczonej dla modeli transformatorów generujących tekst.

Hypernetworks kierują wyniki w określonym kierunku, pozwalając modelom opartym na Stable Diffusion, naśladować styl artystyczny konkretnych twórców, nawet jeśli artyści ci nie są rozpoznawani przez oryginalny model. Realizują to przez wyszukiwanie kluczowych obszarów obrazu (np. włosów czy oczu) i poprawianie tych obszarów we wtórnej przestrzeni ukrytej (ang. Secondary latent space).

DreamBooth

DreamBooth to głęboki model uczenia się opracowany przez naukowców z Google Research i Boston University w 2022 roku, który może być doprecyzowany w celu generowania precyzyjnych, spersonalizowanych obrazów przedstawiających określony obiekt, po przeszkoleniu za pomocą zestawu zdjęć obiektu. DreamBooth pozwala na generowanie obrazów zgodnych z oczekiwaniami, używając zestawów zdjęć użytkowników jako źródła.

Przykładem może być poniższa grafika, wygenerowana przez Stable Diffusion, która przedstawia mój wizerunek.

Wykorzystanie fine-tuningu

Korzystając z powyższych metod, użytkownicy końcowi mogą zastosować proces fine-tuning w celu dostosowania modelu Stable Diffusion do ich specyficznych potrzeb i uzyskania lepszych rezultatów zależnie od przeznaczenia.

Społeczność zgromadzona wokół Stable Diffusion chętnie wykorzystała te możliwości i stworzyła setki, jeśli nie tysiące, rozmaitych modeli bazujących na wersjach od 1.5 do 2.1. Popularnymi stronami gromadzącymi je są między innymi huggingface.co oraz civitai.com.

Każdy z modeli oferuje różne możliwości, często pozwalając wygenerować obrazy w bardzo konkretnym stylu do bardzo konkretnych potrzeb. Przykładem są „concept art” przydatne dla developerów gier czy fotorealistyczne obrazy z dodatkowymi Hypernetworkami kładącymi nacisk na naprawę dłoni, zębów i tekstury skóry, dające wrażenie, że obraz, z którym mamy do czynienia, jest zdjęciem prawdziwej osoby.

Poniżej wykorzystanie modelu Dreamlike Photoreal 2.0, czyli jednego z wielu modeli dążących do fotorealizmu, stworzonych przez społeczność SD na bazie podstawowych modeli dostarczonych przez Stability AI.

Zwłaszcza te ostatnie w połączeniu z metodą DreamBooth pozwalającą nauczyć sieć czyjejś twarzy i sylwetki stanowią pewne ryzyko, gdyż mogą posłużyć do generowania deep fake’ów i wprowadzać tym samy dezinformacje. Jednak dylematy etyczne związane z tą technologią to temat na odrębną dyskusję.

Parametryzacja Stable Diffusion

Mam nadzieję, że nakreśliłem już, o co w tym wszystkim chodzi. Zobaczmy teraz, jakie parametry mają istotny wpływ na końcowy efekt.

Model i prompt

Pierwszą i najważniejszą rzeczą jest oczywiście model i prompt. Model użyty w tej sekcji to jeden z podstawowych modeli od Stability AI w wersji 1.5, a prompt to opis tego, co ma się znaleźć na naszym obrazie. Na potrzeby tego artykułu będzie taki:

photo portrait of programmer woman at work with monitor and keyboard, perfect face, symmetric eyes, cinematic lighting, intricate, elegant, highly detailed, lifelike, photorealistic, (((perfect hands)))

Negatywny prompt

Negatywny prompt to dokładnie to, na co brzmi – jest przeciwieństwem promptu. Opis tego, czego nie chcemy, aby Stable Diffusion generował. Jest to bardzo potężna, ale niedoceniana funkcja, która może nas przybliżyć do osiągnięcia zamierzonych efektów łatwiej i szybciej niż przy wykorzystaniu jedynie pozytywnego promptu.

Nasz negatywny prompt w tym wypadku to:

disfigured, kitsch, ugly, oversaturated, grain, low-res, Deformed, blurry, bad anatomy, poorly drawn face, mutation, mutated, extra limb, ugly, poorly drawn hands, missing limb, blurry, floating limbs, disconnected limbs, malformed hands, blur, out of focus, long neck, long body, ugly, disgusting, poorly drawn, childish, mutilated, mangled, old, surreal, duplicate

Liczba kroków

Stable Diffusion tworzy obraz, zaczynając od szumów i stopniowego ich redukowania, aż do uzyskania finalnego efektu. Ten parametr kontroluje liczbę etapów „odszumiania”. Zazwyczaj im więcej, tym lepiej, ale tylko do pewnego stopnia. Domyślnie używamy 25 kroków, co powinno wystarczyć do generowania dowolnego rodzaju obrazu.

Oto ogólny przewodnik, jaką liczbę kroków użyć w różnych przypadkach:

- Jeśli testujesz nowy prompt i chcesz szybko zobaczyć wyniki, aby dopracować swoje dane wejściowe, użyj 10-15 kroków.

- Gdy znajdziesz prompt, który ci się podoba, zwiększ liczbę kroków do 25.

- W przypadku tworzenia twarzy, zwierzęcia futrzastego lub jakiegokolwiek innego obiektu o szczegółowej teksturze, który może zawierać brakujące detale, spróbuj zwiększyć liczbę kroków do 40!

Niektórzy użytkownicy przyzwyczaili się do generowania obrazów przy użyciu 100 czy 150 kroków, co było przydatne dla próbkowników takich jak LMS. Teraz jednak, dzięki ulepszonym, szybkim próbkownikom, takim jak DDIM i DPM Solver++, używanie tak dużej liczby kroków jest zbędnym zużyciem czasu oraz mocy GPU, bez zwiększenia jakości obrazu. Poprzednie dwa obrazy były wygenerowane przy użyciu 20 kroków. Zobaczmy więc jaki efekt da nam użycie 30 kroków.

Efekt nie jest zachwycający – powiedziałbym nawet, że wygląda to nieco gorzej. Jak się za chwilę przekonamy dużo zależy od próbkownika.

Próbkowniki

Jak już wcześniej wspominałem, modele Diffusion działają przez stopniowe odszumianie początkowego obrazu. W tym miejscu próbkowniki Diffusion rozpoczynają działanie. Mówiąc prościej – są to algorytmy, które po każdym kroku porównują generowany obraz z tym, co treść promptu opisuje, a następnie stopniowo wprowadzają zmiany w szumach, aż obraz przypomina opisany w prompcie.

Trzy najczęściej używane próbkowniki to:

- Euler A,

- DDIM,

- DPM Solver++.

Wypróbujemy wszystkie trzy i zobaczymy, który z nich najlepiej pasuje do naszego promptu. Ponieważ nie ma reguły dotyczącej tego, którego próbkownika używać, warto popróbować kilku. W tym wypadku wszystkie trzy są bardzo szybkie i potrafią wytwarzać spójne wyniki w 15-25 krokach. Do porównania dodam też LMS, aby pokazać, że tam duża liczba kroków zrobi różnicę.

Warto zauważyć, że między próbkownikiem Euler A a pozostałymi trzema istnieje jedyna zauważalna różnica. Porównanie tych próbkowników ujawnia, że obrazy generowane przy użyciu próbkownika Euler A charakteryzują się większą gładkością oraz mniej wyraźnymi krawędziami w porównaniu do obrazów generowanych przez DPM Solver++. Takie właściwości nadają tym obrazom bardziej „nieoczywisty” charakter.

Jeśli więc oczekujesz takiego efektu na swoich generowanych obrazach, zalecane jest stosowanie próbkownika Euler A.

Skala CFG (ang. CFG Guidance Scale)

Ten parametr można rozumieć jako „kreatywność vs. wierność względem promptu”. Niższe wartości dają więcej swobody AI do twórczości, podczas gdy wyższe wartości zmuszają ją do bardziej precyzyjnego przestrzegania promptu.

Domyślna wartość CFG w różnych aplikacjach wynosi około 7, co zapewnia najlepszą równowagę między twórczością a generowaniem tego, co chcesz. Zmniejszenie tej wartości poniżej 5 nie jest zalecane, ponieważ obrazy zaczynają przypominać halucynacje AI, natomiast zwiększenie wartości powyżej 16 może powodować nieestetyczne artefakty na obrazach.

Kiedy więc używać różnych wartości skali CFG? Skalę CFG można podzielić na różne zakresy, każdy odpowiedni dla innego rodzaju promptów i celów.

- CFG 2-6: kreatywny, ale bywa zbyt zniekształcony i niezgodny z promptem. Może być zabawny lub przydatny dla krótkich promptów.

- CFG 7-10: zalecane dla większości promptów. Dobry balans między kreatywnością i kierowanym generowaniem.

- CFG 10-15: gdy jesteś pewien, że Twój prompt jest szczegółowy i bardzo dokładnie opisuje, jak ma wyglądać obraz.

- CFG 16-20: generalnie niezalecane, chyba że prompt jest szczegółowy. Może wpłynąć na spójność i jakość.

- CFG >20: prawie nigdy nieużywane.

Ziarno (ang. Seed)

Ziarno to liczba, która decyduje o początkowym losowym szumie, o którym rozmawialiśmy wcześniej. Ponieważ losowy szum determinuje ostateczny obraz, dzięki ziarnu możemy uzyskać różne obrazy za każdym razem, gdy uruchamiamy ten sam prompt w systemie Stable Diffusion. Możemy także uzyskać ten sam obraz generowany wielokrotnie przy użyciu tego samego promptu i seedu.

Skoro ta sama kombinacja seed i prompt daje ten sam obraz za każdym razem, możemy wykorzystać tę właściwość na wiele sposobów, np. kontrolowanie konkretnych cech postaci. W tym przykładzie zmieniliśmy emocje, ale można też to zastosować do innych cech fizycznych, jak kolor włosów czy karnacji. Im jednak mniejsza zmiana, tym większa szansa na działające rezultaty.

Wszystkie obrazy w tej części artykułu były generowane na tym samym ziarnie: 3947592453.

Zobaczmy teraz, jak dla tego samego promptu i negatywnego promptu oraz standardowych wartości kroków i CFG będzie wyglądał nasz obraz z losowym ziarnem.

Jeżeli macie komputer z kartą graficzną wyposażoną w przynajmniej 8 GB RAM-u, pobranie z gita repozytorium Automatic 1111 umożliwi wam korzystanie z jednego z najpopularniejszych interfejsów graficznych do obsługi Stable Diffusion na własnym komputerze. Jeśli jednak wasz komputer nie spełnia tych wymagań, na Google Colab istnieją implementacje tego interfejsu, które można uruchomić jedynie za cenę tańszego abonamentu Google Colab.

Kilka słów podsumowania

Podsumowując, Stable Diffusion to rewolucyjny model głębokiego uczenia, który potrafi generować obrazy na podstawie opisów tekstowych. Opracowany przez start-up Stability AI, model ten ma szerokie zastosowanie, a dzięki otwartości na społeczność open source, kod źródłowy i wagi modeli są dostępne dla każdego.

Dodatkowo, to co tu zaprezentowałem, to tylko podstawowe opcje „zabawy” ze Stable Diffusion. Społeczność open source zgromadzona wokół projektu stworzyła wiele pluginów Automatic 1111. Wśród nich na szczególną uwagę zasługuje ControlNet pozwalający bardzo precyzyjnie manipulować położeniem postaci w kadrze.

Możliwości jest jednak tak wiele, że omówienie ich wszystkich w jednym artykule jest niemożliwe. Ten ogrom możliwości, kontroli nad obrazem poprzez prompt, personalizowane modele, rozmaite dodatki w połączeniu z otwartością kodu i relatywnie niską ceną, zaczynającą się już od zera złotych (o ile tylko jesteście w posiadaniu dobrego komputera), czyni ze Stable Diffusion może nie najprostszy, ale na pewno najbardziej wszechstronny i najłatwiej dostępny sposób na generowanie obrazów jaki obecnie można znaleźć na rynku.

Zachęcam więc do dalszego samodzielnego zgłębiania tajników Stable Diffusion.

***

A jeśli chcecie dowiedzieć się więcej nt. historii SI w generowaniu obrazów, odsyłamy Was do innego artykułu naszego eksperta.

Zostaw komentarz